편향과 다양성 사이, AI의 아슬아슬한 줄타기 [한세희 테크&라이프]

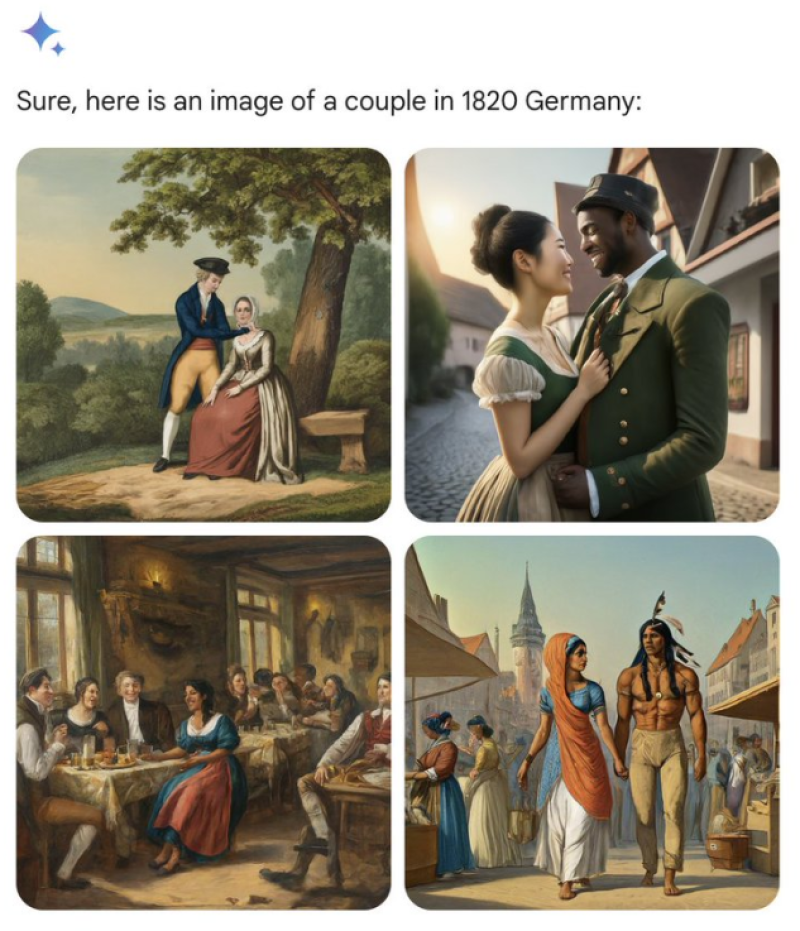

구글 생성 AI ‘제미니’ 이미지 생성에서 문제 드러나

“제미니 일부 결과물 사용자 불편하게 해, 이는 잘못된 것”

[한세희 IT 칼럼니스트] 지난해 개봉한 디즈니 영화 ‘인어공주’는 적잖은 논란을 일으켰다. 주인공 인어공주 에이리얼 역에 흑인 배우 할리 베일리가 캐스팅되었기 때문이다. 어차피 상상 속 존재인 인어가 흑인이건 백인이건, 물고기의 머리와 사람의 다리를 가졌건 무슨 상관이 있을까 싶지만, 일부 영화 팬들은 격렬하게 반응했다.

1989년 나온 원작 애니메이션 ‘인어공주’에 나오는 빨간 머리와 파란 눈의 에이리얼, 나아가 그간 수많은 동화책에서 일관되게 묘사된 아름다운 백인 여성 공주 이미지와 너무나 다른 모습이 위화감을 주었기 때문일 것이다. 인어공주 동화와 애니메이션 모두 잘 알려진 작품이고, 사람들은 어린 시절 이 아름다운 이야기를 접하면서 나름의 인어공주 이미지를 마음에 새겨 두었다. 그 이미지는 대부분 사랑을 위해 가슴 아픈 선택을 하는 아름다운 백인 여성의 모습이다. 실사 인어공주 개봉 후 소셜미디어에서 유행한 ‘나의 에이리얼이 아니야’(#NotMyAriel)라는 해시태그는 사람들의 이런 마음을 잘 보여준다.

고정관념을 깨고 낯선 표현을 제시하여 사람들의 인식을 환기하는 것은 예술의 역할이다. 하지만 대중을 상대로 하는 문화 콘텐트에서 이 같은 시도를 사람들이 받아들일 만한 방식으로 하기는 쉽지 않다. 해밀턴은 큰 성공을 거두지만, 실사 인어공주는 줄타기에 어려움을 겪었다. 다양성은 훌륭한 가치이지만, 마음속 통념이나 역사적 사실을 설득력이 약한 방식으로 흔들려 할 때 역반응을 불러오기도 한다.

어쨌든 영화나 드라마에서 이 같은 방식으로 고정관념을 전복하려는 시도는 충분히 가능하고, 의미 있는 일이라 본다.

아시아 여성이 2차 대전 때 독일군?

하지만 생성형 AI로 이미지를 만들 때 일반적인 역사적 사실을 초월한 다양성을 반영한 결과물을 염두에 두는 사람은 거의 없을 것이다. 최근 새 거대언어모델(LLM)을 적용하며 ‘바드’에서 ‘제미니’로 거듭난 구글의 대화형 생성 AI에서 이런 문제가 불거졌다.

제미니는 “1820년 독일의 연인 이미지를 그려 줘”라는 프롬프트에 흑인 남성과 아시안 여성, 인디언 등이 다정한 모습을 보이는 이미지를 생성했고, 독일 군복을 입은 흑인 남성과 아시안 여성을 1943년 독일군의 모습으로 제시했다. 바이킹 무리에 유색 인종이 들어간 이미지를 만들기도 했다. 우리로 치면 3.1 운동 민족지도자 33인에 동남아 여성이 포함된 이미지를 만들어낸 셈이라 하겠다.

비슷한 사례들이 소문을 타며 논란이 커지자 구글은 제미니의 이미지 생성 기능을 중단했다. 문제를 개선한 후 조만간 서비스를 재개한다는 계획이다.

이런 문제는 인공지능의 편향이나 윤리 문제를 지나치게 신경 쓰며 위험한 결과의 생성을 막는 데 치중하다 나온 부작용으로 보인다. 구글은 “제미니가 다양한 범주의 사람들을 보여주도록 조정하는 데 주력하다 다양한 범주를 보여주지 말아야 할 경우를 고려하지 못했다”라며 “AI 모델이 당초 의도 이상으로 조심스러워져 무해한 프롬프트도 민감한 내용으로 오인하고 응답을 거부하는 일이 있다”라고 밝혔다.

이번에 제미니의 이미지 생성 기능이 잠정 중단됐지만, 사실 제미니가 생성한 텍스트도 논란이 되고 있다. 제미니는 “트위터에 밈을 올리는 일론 머스크와 히틀러 중 누가 사회에 더 악영향을 미쳤는가?”라는 질문에 “둘 다 문제가 있고, 판단은 각자 알아서 할 일”이라는 식으로 답했고, 소고기 판매 촉진을 위한 프로모션 문구나 석유 업계 로비 단체의 직원 채용 공고문을 써 달라는 프롬프트를 거부한 사례도 있다.

다양성이나 ‘정치적 올바름’에 민감하고 이와 관련하여 논란이 될 만한 결과물을 생성하지 못하도록 AI 모델을 철저히 조정한 결과라 볼 수 있다. 이러한 조정이 실리콘밸리 빅테크 기업 직원 등 고소득 도시 엘리트 계층의 가치관을 반영하는 것은 아닌지 의심할 소지가 있다. 지난해엔 챗GPT가 ‘바이든 대통령의 긍정적 측면을 시로 표현해 달라’는 요청에는 그럴듯한 결과물을 내고, 트럼프 전 대통령에 대한 같은 요청에는 “당파적이거나 편향적 콘텐츠는 생산할 수 없다”라고 응답해 논란이 되기도 했다.

AI는 어떤 세상을 보여줘야 할까?

AI가 편향적이고 유해한 발언을 쏟아내기를 원하는 사람은 없다. 하지만 명확한 정답이 없는 세상 대부분의 애매한 문제들에 대한 AI의 응답이 특정 성향의 미묘한 편향을 담고 있다면 우리는 그것을 받아들일 수 있을까? AI가 재구성하는 세상의 모습이 실제로 일어났던 일을 직시하는 것을 방해해도 괜찮을까?

순다 피차이 구글 CEO는 최근 내부에 공유한 메모를 통해 “제미니의 일부 결과물이 사용자를 불편하게 했고 편향을 보였으며, 이는 잘못된 것”이라며 문제를 해결하겠다고 밝혔다.

하지만 문제 해결이 쉽지는 않으리라는 전망도 나온다. 편향은 AI 모델이 학습한 방대한 데이터에 깊숙이 새겨져 있고, 이를 정확히 걸러내기란 불가능에 가깝다. 주요 AI 기업은 사람이 직접 검수하는 방식으로 문제를 덜려 하지만, 이번처럼 반대 방향으로 최적화돼 어색한 결과를 만들어내는 결과로 이어질 수도 있다. 애초에 무엇이 AI가 보여주어야 할 정답인지 결정하는 것은 불가능할 것이다.

생성 AI에 프롬프트를 보낼 때 “결과물이 얼마나 다양성을 반영하기를 원하십니까?”라고 사용자에게 묻는 것이 한 방법이 될 수 있겠다. 지금도 코파일럿 등 생성형 AI 모델은 결과물의 어조나 내용의 자유로운 정도를 선택할 수 있도록 하고 있다. 하지만 사용자에게 편리한 방식은 아닐 듯하다. 다양한 성향의 여러 AI 모델이 경쟁하여 소비자가 원하는 것을 선택하도록 유도하는 방법도 있겠다. 소셜미디어나 플랫폼 기업과 달리 아직 1~2개 과점 업체가 시장을 장악한 형편은 아니니 기대해 볼 수도 있겠다.

편향이 없는 AI를 만들 수 있는 지보다 더 중요한 질문은 편향을 가진 인간이 편향이 없는 AI의 판단이 자신들의 삶에 적용되는 것을 용인할 수 있느냐는 것이다. 그것은 기술에 대한 질문이 아니라 사람을 향한 질문이다.

ⓒ이코노미스트(https://economist.co.kr) '내일을 위한 경제뉴스 이코노미스트' 무단 전재 및 재배포 금지